SG.hu

Így néz ki a mai legerősebb mesterséges intelligencia-szerver

Az Nvidia hétfőn mutatta be az eddigi legerősebb DGX szerverét. A 120 kW-os rack szekrényben lévő 72 új Blackwell lapka az NVLink kapcsolat által lényegében egyetlen nagy GPU-két működik, amely több mint 1,4 exaFLOPS teljesítményre képes FP4 pontossággal.

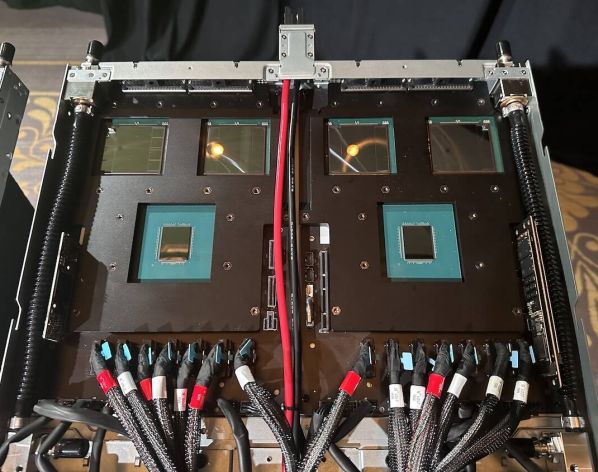

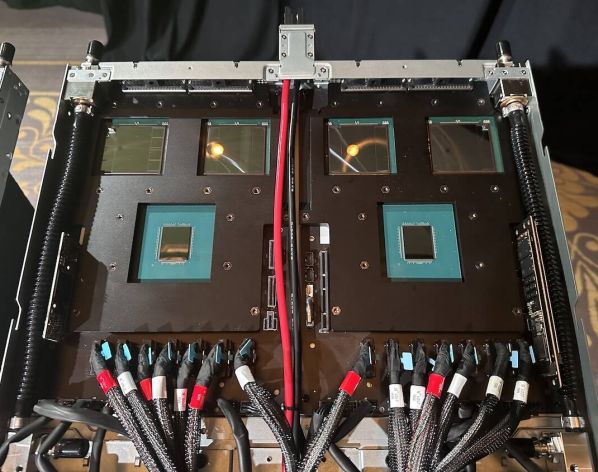

A DGX GB200 NVL72 névre keresztelt rendszer az Nvidia által novemberben bemutatott Grace-Hopper Superchip alapú rack-rendszerek továbbfejlesztése immár több mint kétszer annyi GPU-val. A cég rendezvényén kiállított masina az Nvidia állítása szerint akár 27 trillió paraméteres modellek következtetését is képes támogatni - nem mintha egyelőre lennének ekkora modellek. Bár az 1,36 tonnás rack-rendszert egyetlen nagy GPU-ként forgalmazzák, valójában 18 darab 1U-s számítási csomópontból állítják össze, amelyek mindegyike két darab 2700 Wattos Grace-Blackwell Superchippel (GB200) van felszerelve.

A képen két GB200 Superchip hőelvezetés nélkül egy 1U magas folyadékhűtéses házban.

Mindegyik Superchip 864 GB memóriával van felszerelve - 480 GB LPDDR5x és 384 GB HBM3e - és az Nvidia szerint 40 petaFLOPS FP4 teljesítményre képes. Ez azt jelenti, hogy minden egyes számítási csomópont 80 petaFLOPS MI-számítási teljesítményre képes, a teljes rack tudása pedig 1,44 exaFLOPS.

A Grace-Blackwell Superchip (vagy röviden GB200) egy 72 Arm-magos CPU-t kombinál két 1200 W-os GPU-val.

A néhány menedzsmentport mellett az alaplapon négy kisméretű NVMe csatlakozó is található. A számítási hálózatot a rendszer elején (az előlap bal és középső részén) lévő négy InfiniBand NIC alkotja. Ezek egy BlueField-3 DPU-val is fel vannak szerelve, amely a tárolóhálózattal való kommunikáció kezeléséért felelős.

Az NVL72 18 számítási csomópontja alapfelszereltségként négy Connect-X InfiniBand NIC-vel és egy BlueField-3 DPU-val rendelkezik.

A két GB200 Superchip és az öt NIC miatt a csomópontok fogyasztása darabonként 5,4 és 5,7 kW között van. Ennek a hőnek a túlnyomó többségét direct-to-chip (DTC) folyadékhűtés vezeti el. Az Nvidia által a GTC-n bemutatott DGX-rendszerek nem rendelkeztek hűtőlemezzel, de bemutatták néhány partner prototípusát, például ezt a Lenovo rendszert. Míg a HPE Cray vagy a Lenovo Neptune termékcsalád HPC-központú csomópontjainál mindent folyadékkal hűtenek, az Nvidia úgy döntött, hogy az alacsony fogyasztású perifériákat, például az NIC-ket és a rendszertárolókat hagyományos 40 mm-es ventilátorokkal hűti.

Az Nvidia által bemutatott GB200-as rendszerekben nem volt hűtés, ez a Lenovo prototípus megmutatja, hogyan nézhet ki a gyártás során.

Jensen Huang a bemutató során az NVL72-t egyetlen nagy GPU-ként jellemezte. Ez azért van így, mert mind a 18 számítási csomópontot egy kilenc NVLink-kapcsolóból álló köteg köti össze, amely a rack közepén helyezkedik el. Ezek a rendszer 72 GPU-jának egyenként 1,8 TBps kétirányú sávszélességet biztosítanak. Ez ugyanaz a technológia, amelyet az Nvidia HGX csomópontjai is használtak, hogy a nyolc GPU egyetlenként viselkedjen. Eltérés viszont, hogy az NVLink-kapcsoló alaplapra forrasztása helyett az NVL72-ben ez egy önálló készülék.

Az NVLink kapcsoló hagyományosan az Nvidia SXM hordozó lapjaiba van beépítve, mint például az itt látható Blackwell HGX lapnál

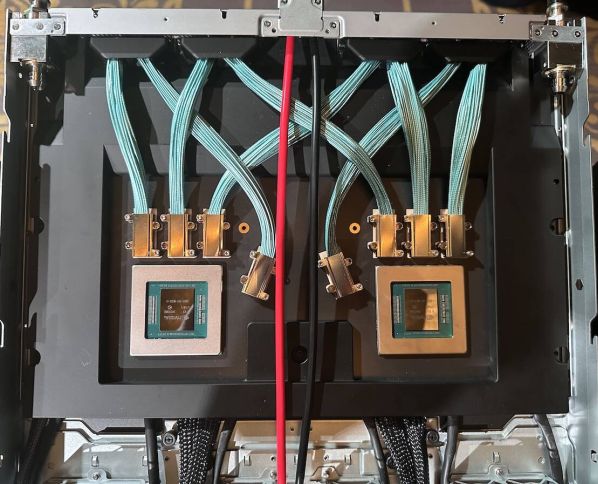

Ezeknek a kapcsolóknak a belsejében egy pár Nvidia NVLink 7.2T ASIC található, amelyek összesen 144 darab 100 GBps sebességű kapcsolatot biztosítanak. Rackenként kilenc NVLink-kapcsolóval számolva ez 1,8 TBps - 18 link - kétirányú sávszélességet jelent a rackben lévő 72 GPU mindegyike számára.

A képen két 5. generációs NVLink ASICS látható.

Mindezek egy több mint 3,2 km hosszú rézkábeles vakcsatlakozós háttértárba illeszkednek. A rack hátsó részén átnézve homályosan kivehető a hatalmas kábelköteg, amely a GPU-kat egymáshoz kapcsolja, hogy azok egyként működhessenek. De miért használtak rézkábeleket optikai helyett? Ez furcsának tűnhet a szükséges sávszélességet tekintve, de az ok egyszerű: az optika támogatásához szükséges adó-vevőegységek további 20 kW-ot adtak volna a rendszer amúgy is hatalmas teljesítményfelvételéhez. Ugyanez az oka annak is, hogy az NVLink kapcsolókat a számítási csomópontok közé rakták, mivel így minimálisra csökkenthető a kábelek hossza.

A hátlap mögött látható a hatalmas kábelköteg.

A rack tetejére két 52 portos Spectrum switchet raktak 48 gigabites RJ45 és négy QSFP28 100 Gbps porttal. Ezeket a switcheket a rendszert alkotó különböző számítási csomópontok, NVLink kapcsolók és tápegységek menedzsmentjére és a telemetria streamelésére használják. Közvetlenül ezek alá került három polcnyi tápegység - ezeken kívül még van három sornyi az alján is. Ezek felelősek a 120 kW-os rack tápellátásáért. Gyorsan kiszámolva hat darab 415V-os, 60A-s tápegység elegendő lenne, de feltehetően az Nvidia vagy hardverpartnerei valamilyen szintű redundanciát beépítettek a tervezés során. Ez arra enged következtetni, hogy ezek 60A-nál többel is működhetnek. Az áramellátást egy egyenáramú sín biztosítja, amely a rack hátulján fut végig.

A switchek alatt a hatból három tápegység-polc látható.

Természetesen 120 kW-os számítási kapacitás hűtése nem éppen triviális feladat. De mivel a chipek egyre forróbbak, a számítási igények pedig egyre nagyobbak, egyre több vállalat - köztük a Digital Realty és az Equinix - dolgozik keményen a nagy sűrűségű HPC- és MI-szerverek kiszolgálásán. Az Nvidia NVL72 esetében mind a számítási, mind az NVLink kapcsolók folyadékhűtésűek. Huang szerint másodpercenként két liter 25 Celsius-fokos hűtőfolyadék lép be a rackbe, és 20 fokkal melegebben lép ki onnan.

Másodpercenként 2 liter folyadékot pumpálnak át az állványon.

De mindez csak egyetlen szekrény, így akinek nem elég 13,5 TB HBM3e memória és és 1,44 exaFLOPS számítási kapacitás, nyitva áll előtte a lehetőség, hogy ezekből nyolcat hálózatba kapcsoljon, így egy nagy, 576 GPU-t tartalmazó DGX Superpodot lehet létrehozni.

Ha pedig még többre van szükség a képzési munkaterhelések támogatásához, akkor a rendszer még tovább skálázható, és további Superpodok adhatók hozzá. Az Amazon Web Services pontosan ezt teszi a Ceiba projekt keretében. Az eredetileg novemberben bejelentett MI szuperszámítógép az Nvidia DGX GB200 NVL72-es DGX GB200 NVL72-jét használja sablonként. Amikor elkészül, a gép 20 736 (húszezer hétszázharminchat) GB200-as gyorsítóval fog rendelkezni. Ez a rendszer azonban annyiban egyedi, hogy a Ceiba az AWS saját fejlesztésű Elastic Fabric Adapter (EFA) hálózatát fogja használni, nem pedig az Nvidia InfiniBand készletét.

A DGX GB200 NVL72 névre keresztelt rendszer az Nvidia által novemberben bemutatott Grace-Hopper Superchip alapú rack-rendszerek továbbfejlesztése immár több mint kétszer annyi GPU-val. A cég rendezvényén kiállított masina az Nvidia állítása szerint akár 27 trillió paraméteres modellek következtetését is képes támogatni - nem mintha egyelőre lennének ekkora modellek. Bár az 1,36 tonnás rack-rendszert egyetlen nagy GPU-ként forgalmazzák, valójában 18 darab 1U-s számítási csomópontból állítják össze, amelyek mindegyike két darab 2700 Wattos Grace-Blackwell Superchippel (GB200) van felszerelve.

A képen két GB200 Superchip hőelvezetés nélkül egy 1U magas folyadékhűtéses házban.

Mindegyik Superchip 864 GB memóriával van felszerelve - 480 GB LPDDR5x és 384 GB HBM3e - és az Nvidia szerint 40 petaFLOPS FP4 teljesítményre képes. Ez azt jelenti, hogy minden egyes számítási csomópont 80 petaFLOPS MI-számítási teljesítményre képes, a teljes rack tudása pedig 1,44 exaFLOPS.

A Grace-Blackwell Superchip (vagy röviden GB200) egy 72 Arm-magos CPU-t kombinál két 1200 W-os GPU-val.

A néhány menedzsmentport mellett az alaplapon négy kisméretű NVMe csatlakozó is található. A számítási hálózatot a rendszer elején (az előlap bal és középső részén) lévő négy InfiniBand NIC alkotja. Ezek egy BlueField-3 DPU-val is fel vannak szerelve, amely a tárolóhálózattal való kommunikáció kezeléséért felelős.

Az NVL72 18 számítási csomópontja alapfelszereltségként négy Connect-X InfiniBand NIC-vel és egy BlueField-3 DPU-val rendelkezik.

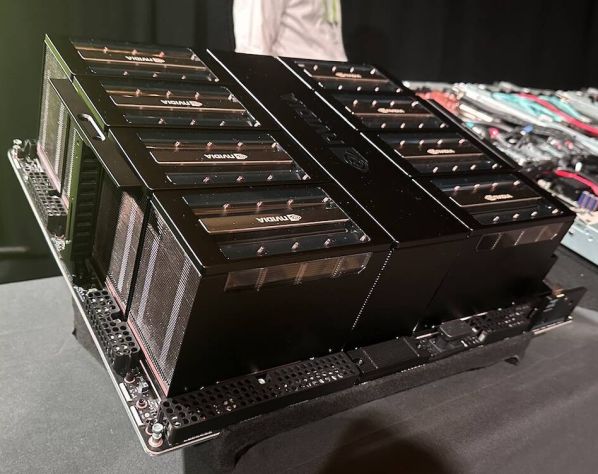

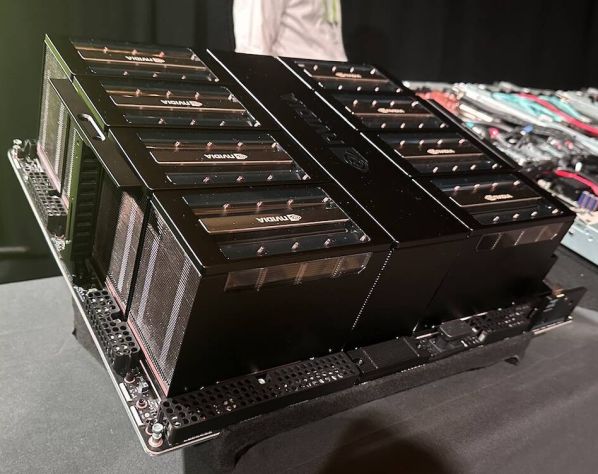

A két GB200 Superchip és az öt NIC miatt a csomópontok fogyasztása darabonként 5,4 és 5,7 kW között van. Ennek a hőnek a túlnyomó többségét direct-to-chip (DTC) folyadékhűtés vezeti el. Az Nvidia által a GTC-n bemutatott DGX-rendszerek nem rendelkeztek hűtőlemezzel, de bemutatták néhány partner prototípusát, például ezt a Lenovo rendszert. Míg a HPE Cray vagy a Lenovo Neptune termékcsalád HPC-központú csomópontjainál mindent folyadékkal hűtenek, az Nvidia úgy döntött, hogy az alacsony fogyasztású perifériákat, például az NIC-ket és a rendszertárolókat hagyományos 40 mm-es ventilátorokkal hűti.

Az Nvidia által bemutatott GB200-as rendszerekben nem volt hűtés, ez a Lenovo prototípus megmutatja, hogyan nézhet ki a gyártás során.

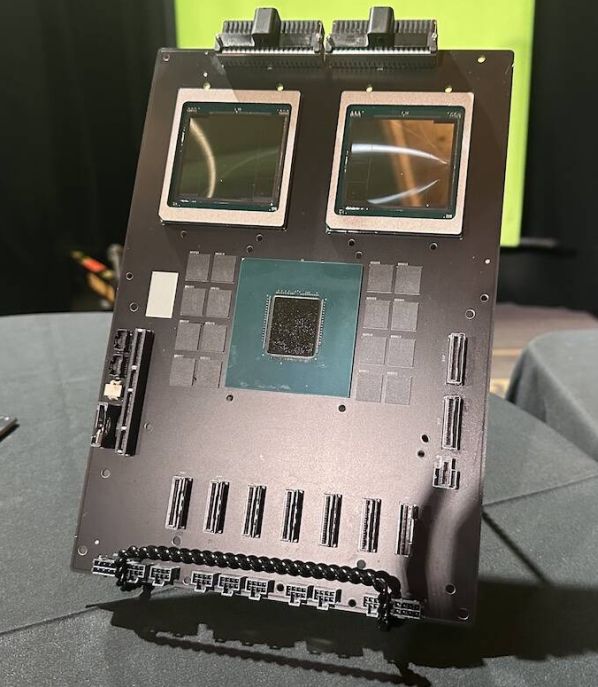

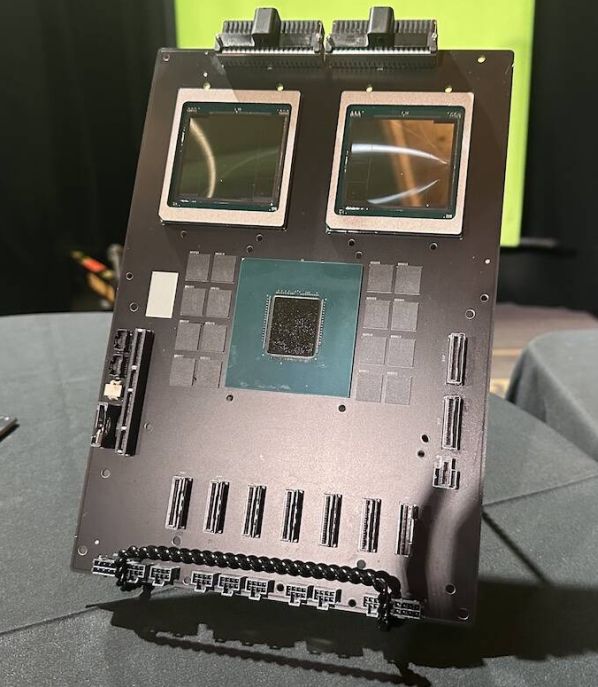

Jensen Huang a bemutató során az NVL72-t egyetlen nagy GPU-ként jellemezte. Ez azért van így, mert mind a 18 számítási csomópontot egy kilenc NVLink-kapcsolóból álló köteg köti össze, amely a rack közepén helyezkedik el. Ezek a rendszer 72 GPU-jának egyenként 1,8 TBps kétirányú sávszélességet biztosítanak. Ez ugyanaz a technológia, amelyet az Nvidia HGX csomópontjai is használtak, hogy a nyolc GPU egyetlenként viselkedjen. Eltérés viszont, hogy az NVLink-kapcsoló alaplapra forrasztása helyett az NVL72-ben ez egy önálló készülék.

Az NVLink kapcsoló hagyományosan az Nvidia SXM hordozó lapjaiba van beépítve, mint például az itt látható Blackwell HGX lapnál

Ezeknek a kapcsolóknak a belsejében egy pár Nvidia NVLink 7.2T ASIC található, amelyek összesen 144 darab 100 GBps sebességű kapcsolatot biztosítanak. Rackenként kilenc NVLink-kapcsolóval számolva ez 1,8 TBps - 18 link - kétirányú sávszélességet jelent a rackben lévő 72 GPU mindegyike számára.

A képen két 5. generációs NVLink ASICS látható.

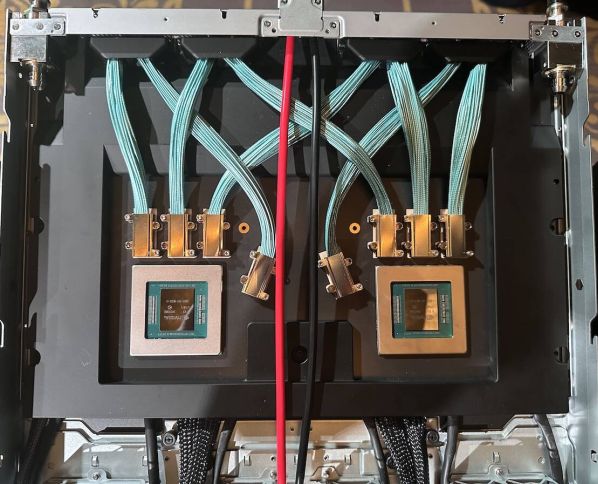

Mindezek egy több mint 3,2 km hosszú rézkábeles vakcsatlakozós háttértárba illeszkednek. A rack hátsó részén átnézve homályosan kivehető a hatalmas kábelköteg, amely a GPU-kat egymáshoz kapcsolja, hogy azok egyként működhessenek. De miért használtak rézkábeleket optikai helyett? Ez furcsának tűnhet a szükséges sávszélességet tekintve, de az ok egyszerű: az optika támogatásához szükséges adó-vevőegységek további 20 kW-ot adtak volna a rendszer amúgy is hatalmas teljesítményfelvételéhez. Ugyanez az oka annak is, hogy az NVLink kapcsolókat a számítási csomópontok közé rakták, mivel így minimálisra csökkenthető a kábelek hossza.

A hátlap mögött látható a hatalmas kábelköteg.

A rack tetejére két 52 portos Spectrum switchet raktak 48 gigabites RJ45 és négy QSFP28 100 Gbps porttal. Ezeket a switcheket a rendszert alkotó különböző számítási csomópontok, NVLink kapcsolók és tápegységek menedzsmentjére és a telemetria streamelésére használják. Közvetlenül ezek alá került három polcnyi tápegység - ezeken kívül még van három sornyi az alján is. Ezek felelősek a 120 kW-os rack tápellátásáért. Gyorsan kiszámolva hat darab 415V-os, 60A-s tápegység elegendő lenne, de feltehetően az Nvidia vagy hardverpartnerei valamilyen szintű redundanciát beépítettek a tervezés során. Ez arra enged következtetni, hogy ezek 60A-nál többel is működhetnek. Az áramellátást egy egyenáramú sín biztosítja, amely a rack hátulján fut végig.

A switchek alatt a hatból három tápegység-polc látható.

Természetesen 120 kW-os számítási kapacitás hűtése nem éppen triviális feladat. De mivel a chipek egyre forróbbak, a számítási igények pedig egyre nagyobbak, egyre több vállalat - köztük a Digital Realty és az Equinix - dolgozik keményen a nagy sűrűségű HPC- és MI-szerverek kiszolgálásán. Az Nvidia NVL72 esetében mind a számítási, mind az NVLink kapcsolók folyadékhűtésűek. Huang szerint másodpercenként két liter 25 Celsius-fokos hűtőfolyadék lép be a rackbe, és 20 fokkal melegebben lép ki onnan.

Másodpercenként 2 liter folyadékot pumpálnak át az állványon.

De mindez csak egyetlen szekrény, így akinek nem elég 13,5 TB HBM3e memória és és 1,44 exaFLOPS számítási kapacitás, nyitva áll előtte a lehetőség, hogy ezekből nyolcat hálózatba kapcsoljon, így egy nagy, 576 GPU-t tartalmazó DGX Superpodot lehet létrehozni.

Ha pedig még többre van szükség a képzési munkaterhelések támogatásához, akkor a rendszer még tovább skálázható, és további Superpodok adhatók hozzá. Az Amazon Web Services pontosan ezt teszi a Ceiba projekt keretében. Az eredetileg novemberben bejelentett MI szuperszámítógép az Nvidia DGX GB200 NVL72-es DGX GB200 NVL72-jét használja sablonként. Amikor elkészül, a gép 20 736 (húszezer hétszázharminchat) GB200-as gyorsítóval fog rendelkezni. Ez a rendszer azonban annyiban egyedi, hogy a Ceiba az AWS saját fejlesztésű Elastic Fabric Adapter (EFA) hálózatát fogja használni, nem pedig az Nvidia InfiniBand készletét.